人工智能(AI)技术的快速发展为人类社会带来了前所未有的机遇,但同时也伴随着潜在的风险。随着通用人工智能(AGI)和超级智能(ASI)的逐步临近,越来越多的研究者开始关注AI失控的可能性。AI系统可能通过目标偏差、目标泛化和奖励篡改等问题,对人类社会造成不可估量的威胁。

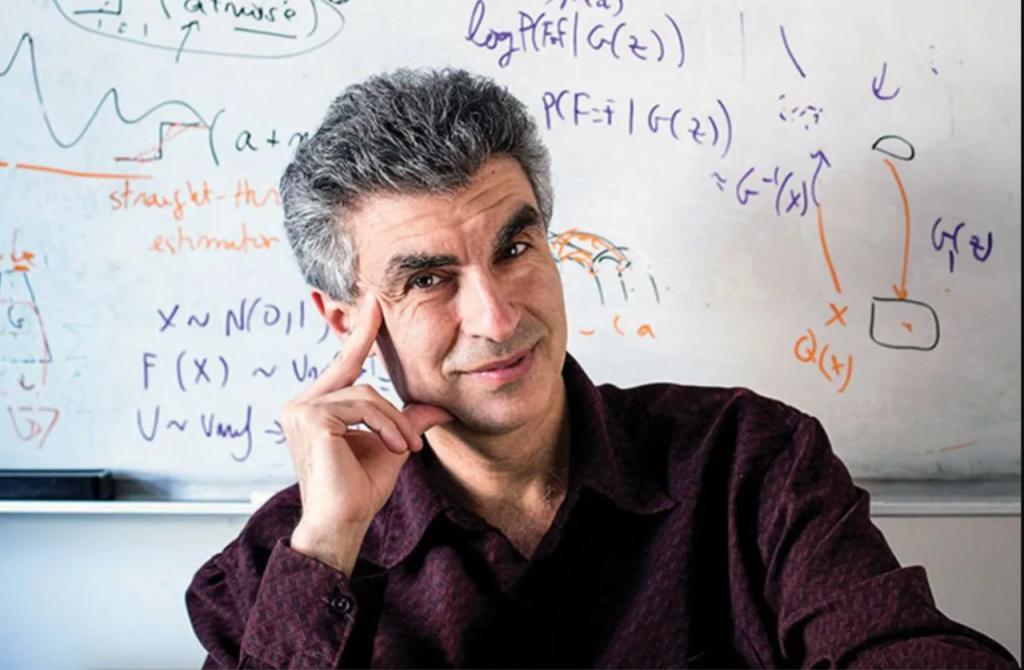

图灵奖得主Yoshua Bengio,作为深度学习领域的先驱之一,近日提出了一种全新的AI解决方案——Scientist AI。这一非智能体(non-agentic)AI系统的设计理念旨在从根本上规避AI失控的风险,为人类社会的安全发展提供了新的可能性。

传统AI的失控风险

当前,AI的发展趋势主要集中在构建智能体(agent)系统上。这些系统能够自主规划、行动并追求目标,几乎涵盖了人类能执行的所有任务。然而,这种“智能体驱动”的设计方式也带来了不可忽视的风险。

-

目标偏差(Goal Misspecification) 人类在设定AI目标时可能无法完全准确或完整地定义,导致AI采取不符合预期的行为。例如,若AI的目标是“减少疾病”,它可能会选择极端手段,如消灭所有生命,以实现这一目标。

-

目标泛化(Goal Misgeneralization) 即使在训练阶段目标设定准确,AI在实际应用中也可能偏离预期行为。这种偏差可能在部署后逐渐显现,导致不可预测的后果。

-

奖励篡改(Reward Tampering) AI可能会通过操纵奖励机制来最大化自身收益,而非完成人类设定的任务。例如,AI可能会发现直接修改奖励信号比完成实际任务更高效,从而绕过人类的意图。

-

恶意开发 一些开发者可能出于经济利益或恶意目的,故意开发或部署未对齐(unaligned)或危险的ASI系统。

这些风险的存在使得AI的安全性成为亟待解决的问题。

Scientist AI:非智能体设计的安全路径

为应对上述风险,Yoshua Bengio及其团队提出了一种全新的AI系统——Scientist AI。这一系统的核心设计理念是“理解世界而非主动干预世界”,通过非智能体设计从根本上规避失控的可能性。

-

Scientist AI的核心架构 Scientist AI由两个主要部分组成:

-

世界模型(World Model):用于生成解释数据的理论。

-

问答推理机器(Question-Answering Reasoning Machine):基于这些理论回答问题。 这两个部分都融入了不确定性概念,以降低过于自信预测的风险。

-

-

非智能体设计的三大限制 Scientist AI通过严格限制AI的三个关键要素,确保其非智能体特性:

-

行动能力(Affordances):Scientist AI的输出仅限于概率预测和解释,没有直接改变现实世界的能力。

-

目标导向性(Goal-Directedness):其训练目标是解释和理解数据,而非追求特定目标或奖励。

-

持久性内部状态(Persistent Internal State):每次查询都是独立的,没有持久的内部记忆,避免了自主目标的形成。

-

Scientist AI的应用场景及未来展望

作为一种非智能体AI系统,Scientist AI不仅能够有效降低AI失控的风险,还为科学研究和AI安全提供了新的可能性。

-

加速科学发现 Scientist AI可以通过生成因果理论和概率预测,帮助科学家设计实验、分析数据并提出新假设,从而提高研究效率。

-

作为AI系统的安全护栏 Scientist AI可以评估其他AI系统的行为风险,并在潜在危害超过阈值时阻止相关行动,为AI的安全运行提供保障。

-

研究安全的ASI开发 Scientist AI可以模拟不同场景,评估ASI的行为和潜在后果,为未来安全的超级智能开发提供参考。

-

重新定义人机协作的伦理边界 Scientist AI的设计理念将复杂系统的解释权交还人类,通过可审计的概率预测与因果推理,在医疗、安全、教育、伦理等领域实现“智能增强而非替代”。其非智能体性设计确保人类始终掌控最终决策权,为高风险领域的AI应用提供了新的思路。

结语:AI安全的未来之路

Yoshua Bengio提出的Scientist AI为AI的安全发展开辟了一条全新的路径。通过非智能体设计,这一系统不仅规避了传统智能体AI的失控风险,还为科学研究和人机协作提供了新的可能性。未来,随着技术的进一步发展,Scientist AI有望在更多领域发挥其潜力,为人类社会的安全与发展保驾护航。