一、通古大模型是什么?

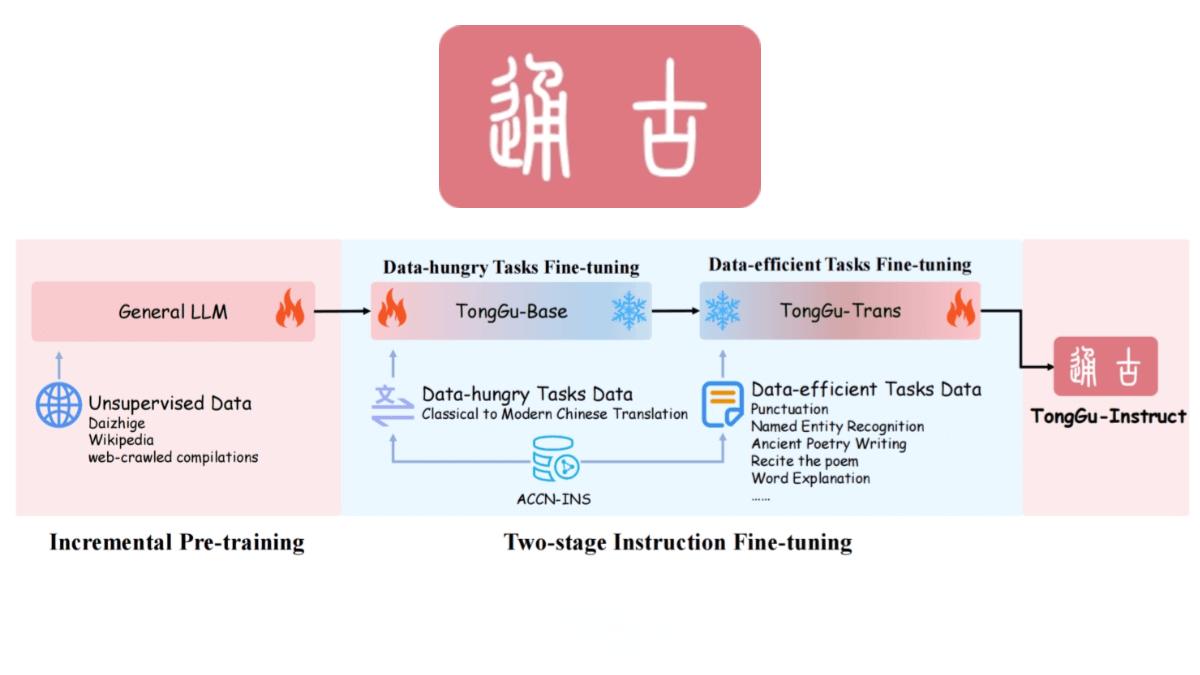

通古大模型是华南理工大学深度学习与视觉计算实验室(SCUT-DLVCLab)推出的专注于古籍文言文处理的AI语言模型。它基于百川2-7B-Base进行增量预训练,利用24.1亿古籍语料进行无监督训练,并结合400万古籍对话数据进行指令微调。通过冗余度感知微调(RAT)技术和检索增强生成(RAG)技术,通古大模型在古籍处理任务中表现出色,帮助用户更便捷地理解和翻译古籍文献。

二、通古大模型的主要功能

-

古文句读 通古大模型能够自动为古文添加标点符号,解决古籍中常见的断句问题,帮助用户更好地理解古文内容。

-

文白翻译 模型支持文言文与白话文之间的双向翻译,将晦涩的古文翻译为现代文,同时也可将现代文转换为文言文,方便用户进行古籍阅读和研究。

-

诗词创作 通古大模型可以生成符合古诗词格律和风格的诗歌,用户可以根据需求提供主题或关键词,模型生成相应的诗词作品。

-

古籍赏析 模型能对古籍中的经典篇章进行赏析,解读其文学价值、历史背景和文化内涵,辅助用户深入学习古籍。

-

古籍检索与问答 结合检索增强技术,通古大模型可以快速检索古籍内容,根据用户的问题提供准确的答案,帮助用户高效获取古籍信息。

-

辅助古籍整理 模型能识别古籍中的文字错误、缺漏等问题,提供修复建议,辅助古籍整理和数字化工作。

三、通古大模型的技术原理

-

基础模型架构 通古大模型基于百川2-7B-Base进行增量预训练,该模型为通古大模型提供了基础的语言理解和生成能力。

-

无监督增量预训练 模型在24.1亿古籍语料上进行无监督增量预训练,使模型学习古籍的语言风格和结构,为后续的古籍处理任务奠定基础。

-

多阶段指令微调 通古大模型采用了多阶段指令微调技术,提出了冗余度感知微调(RAT)方法。在提升下游任务性能的同时,保留了基座模型的能力。

-

检索增强生成(RAG)技术 通古大模型结合了检索增强生成(RAG)技术,减少知识密集型任务中的幻觉问题,提高生成内容的准确性和可靠性。

四、通古大模型的项目地址

-

HuggingFace模型库:https://huggingface.co/SCUT-DLVCLab/TongGu-7B-Instruct

五、通古大模型的应用场景

-

古籍处理与数字化 通古大模型能高效处理古籍文献,支持文白翻译、句读标点和古籍检索等功能,辅助古籍整理工作,提升古籍数字化的效率。

-

教育支持 教师可以利用通古大模型生成教案、教学PPT,设计课堂互动环节。学生则可以通过模型获得文言文翻译、成语解释和诗词创作等功能,帮助他们更好地理解古文。

-

文化传承与普及 通古大模型通过降低古籍阅读难度,让更多人接触和理解中华传统文化,促进文化传承与普及。

-

学术研究 通古大模型为古籍研究提供了强大的技术支持,帮助学者快速检索和分析古籍内容,提升研究效率。

六、通古大模型的意义与未来展望

通古大模型的推出,不仅是古籍处理领域的一次重要突破,也为中华传统文化的传承与普及提供了强有力的技术支持。未来,随着技术的不断进步,通古大模型有望在更多领域发挥其独特优势,助力古籍数字化和文化传承迈向新的高度。

结语

通古大模型作为华南理工大学推出的专注于古籍文言文处理的AI语言模型,凭借其强大的功能和技术优势,正在为古籍数字化和文化传承开辟新的道路。无论是教育工作者、研究人员,还是普通用户,都能从中受益,感受古籍的魅力与智慧。