在AI技术飞速发展的今天,视频生成技术正在成为各个行业的焦点。无论是影视制作、广告营销,还是虚拟现实,高质量的视频内容需求日益增长。然而,传统的视频生成技术往往受限于角色控制的灵活性和视频质量的稳定性,难以满足多样化的需求。

AnyCharV的出现,为这一领域带来了革命性的突破。由香港中文大学、清华大学深圳国际研究生院和香港大学联合开发的AnyCharV,是一款角色可控的视频生成框架。它通过创新的两阶段训练策略,实现了高质量的角色视频生成,同时支持复杂的人-物交互和背景融合。本文将详细介绍AnyCharV的功能、技术原理及其应用场景,帮助读者全面了解这一前沿AI工具。

AnyCharV的主要功能:灵活高效的角色视频生成

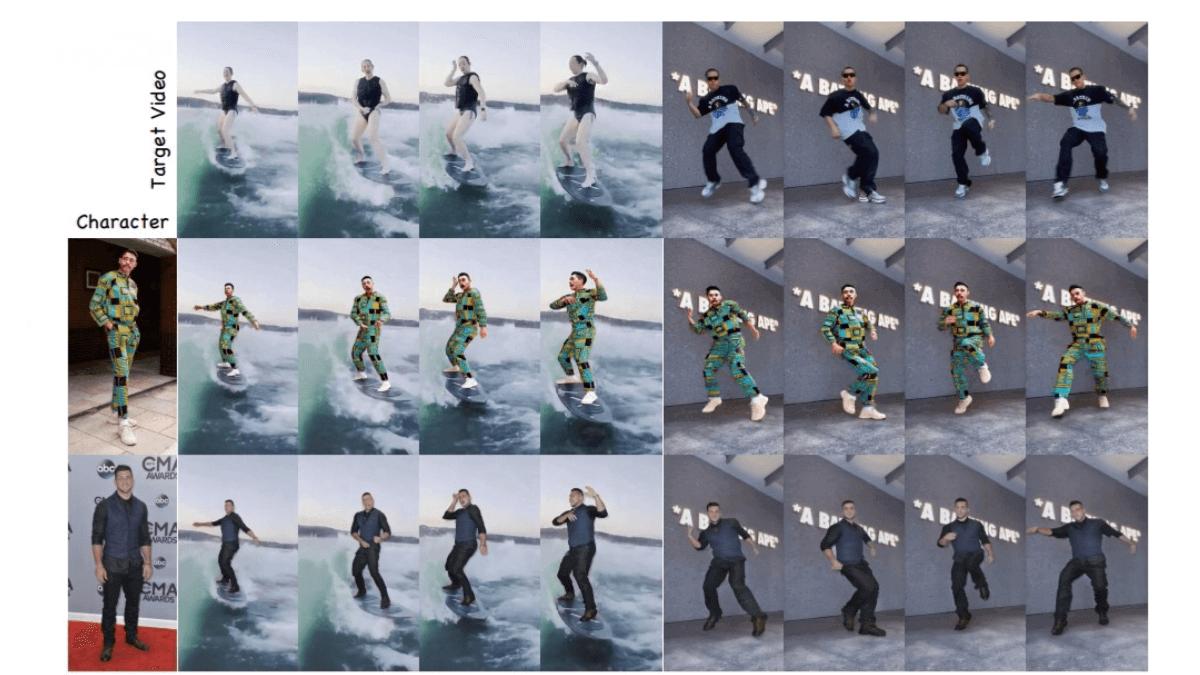

AnyCharV的核心功能在于其强大的角色可控能力。它能够将任意给定的角色图像与目标驱动视频相结合,生成自然、高质量的视频。以下是AnyCharV的主要功能亮点:

-

任意角色与目标场景的合成 AnyCharV支持将任意角色图像与目标驱动视频结合,生成自然流畅的视频内容。无论是电影中的虚拟角色,还是广告中的产品代言人,AnyCharV都能轻松实现角色与场景的无缝融合。

-

高保真角色细节保留 通过自增强训练和粗粒度掩码引导,AnyCharV能够精确保留角色的外观和细节,避免传统视频生成技术中常见的失真问题。这意味着生成的视频不仅质量高,还能真实还原角色的特征。

-

复杂场景与人-物交互 AnyCharV支持角色在复杂背景下的自然交互,如运动、物体操作等。无论是影视特效中的动作场景,还是虚拟现实中的互动体验,AnyCharV都能提供高质量的支持。

-

灵活的输入支持 AnyCharV不仅能够处理传统的图像和视频输入,还能与文本到图像(T2I)和文本到视频(T2V)模型生成的内容相结合,展现出强大的泛化能力。

AnyCharV的技术原理:两阶段训练策略

AnyCharV的技术优势源于其创新的两阶段训练策略。这一策略通过精细到粗略的引导,确保生成视频的质量和自然度。

-

第一阶段:自监督合成与细粒度引导 在第一阶段,AnyCharV利用目标角色的分割掩码和姿态信息作为条件信号,将参考角色精确地合成到目标场景中。同时,引入参考图像的CLIP特征和ReferenceNet提取的角色外观特征,进一步保留角色的身份和外观。通过对分割掩码进行强增强,AnyCharV有效减少了因形状差异导致的细节丢失。

-

第二阶段:自增强训练与粗粒度引导 在第二阶段,AnyCharV通过生成的视频对进行自增强训练,并用粗略的边界框掩码代替细分割掩码。这种方法减少了对角色形状的约束,使模型能够更好地保留参考角色的细节,并在推理阶段生成更自然的视频。

AnyCharV的应用场景:多领域创新实践

AnyCharV的泛化能力和高质量输出使其在多个领域具有广泛的应用潜力。以下是AnyCharV的主要应用场景:

-

影视制作 在影视特效制作中,AnyCharV能够快速将任意角色合成到目标场景中,支持复杂的人-物交互,大幅提高特效制作的效率和质量。

-

艺术创作 AnyCharV结合文本生成内容,能够快速生成高质量的角色视频,激发艺术家的创意灵感,为数字艺术创作提供更多可能性。

-

虚拟现实 在虚拟现实领域,AnyCharV可以实时生成角色与虚拟场景的交互视频,增强用户的沉浸感,为VR应用提供更丰富的体验。

-

广告营销 AnyCharV支持快速合成个性化广告视频,满足广告行业的多样化需求,帮助企业打造更具吸引力的营销内容。

-

教育培训 通过生成特定角色和场景的视频,AnyCharV能够辅助教学和培训,为教育行业提供更直观、更生动的教学工具。

AnyCharV的资源链接:探索更多可能性

如果你对AnyCharV感兴趣,可以通过以下链接深入了解:

-

项目官网:AnyCharV官方网站

-

GitHub仓库:AnyCharV GitHub

-

技术论文:AnyCharV arXiv论文

结语:AnyCharV的未来展望

AnyCharV作为一款由顶尖高校联合开发的角色可控视频生成框架,不仅展现了AI技术的前沿水平,也为多个行业提供了创新的解决方案。无论是影视制作、艺术创作,还是虚拟现实和教育培训,AnyCharV都展现出了巨大的应用潜力。

未来,随着AI技术的不断进步,AnyCharV有望在更多领域中发挥其独特的优势,为用户提供更高质量的视频生成体验。如果你正在寻找一款灵活高效的角色视频生成工具,不妨深入了解AnyCharV,探索它为你的项目带来的无限可能。