Aya Vision 是 Cohere 开发的一种多模态、多语言视觉模型,发布于 2025 年 3 月 3 日,旨在提升全球范围内的多语言和多模态通信能力。根据 Cohere 博客:Aya Vision:扩展 AI 所能看到的世界,该模型支持 23 种主要语言,覆盖全球一半以上人口的语言需求,特别适合多语言环境下的视觉内容处理。

主要功能

Aya Vision 的功能设计全面,涵盖以下几个方面:

-

图像描述生成

该功能允许用户上传图像,模型生成准确且详细的描述文本。这对于视觉障碍人士或需要快速提取图像信息的场景尤为重要。例如,学生可以通过图像描述快速了解艺术品的风格和起源,增强学习体验。 -

视觉问答(VQA)

用户可以上传图片并提出相关问题,Aya Vision 结合视觉信息和语言理解能力,提供准确的答案。这种交互式功能在教育和内容创作领域具有广泛的应用潜力,例如教师可以用它回答学生关于生物图谱的问题。 -

多语言支持

Aya Vision 支持 23 种主要语言,能够处理多语言的文本输入和输出。 -

文本翻译与摘要生成

除了视觉任务,Aya Vision 还能翻译文本内容并生成简洁的摘要,帮助用户快速获取关键信息。这在跨语言交流和信息处理中尤为实用,例如研究人员阅读外文论文时可快速获取要点。 -

跨模态理解与生成

该模型能够将视觉信息与语言信息相结合,实现跨模态的交互。例如,它可以将图像内容转化为文本描述,或将文本指令转化为视觉搜索结果,这在广告创意或内容生成中非常有用。

技术原理

Aya Vision 采用模块化架构,包含以下核心组件:

-

视觉编码器:基于 SigLIP2-patch14-384,负责提取图像特征。

-

视觉语言连接器:将图像特征映射到语言模型的嵌入空间。

-

语言模型解码器:用于生成文本输出。

训练过程中,Aya Vision 使用合成标注(由 AI 生成的标注)进行训练,通过翻译和重述处理增强多语言数据的质量。模型还采用了动态图像分辨率处理和像素混洗下采样技术,提高计算效率。根据 TechCrunch:Cohere 声称其新 Aya Vision AI 模型为最佳,尽管参数规模较小(8B 和 32B),Aya Vision 在多个基准测试中超越了更大规模的模型,如 Llama-3.2 90B Vision,这得益于高效的训练策略和对计算资源的优化。

训练分为两个阶段:

- 视觉语言对齐:确保图像和文本表示的一致性。

- 监督微调:在多模态任务上联合训练连接器和语言模型。

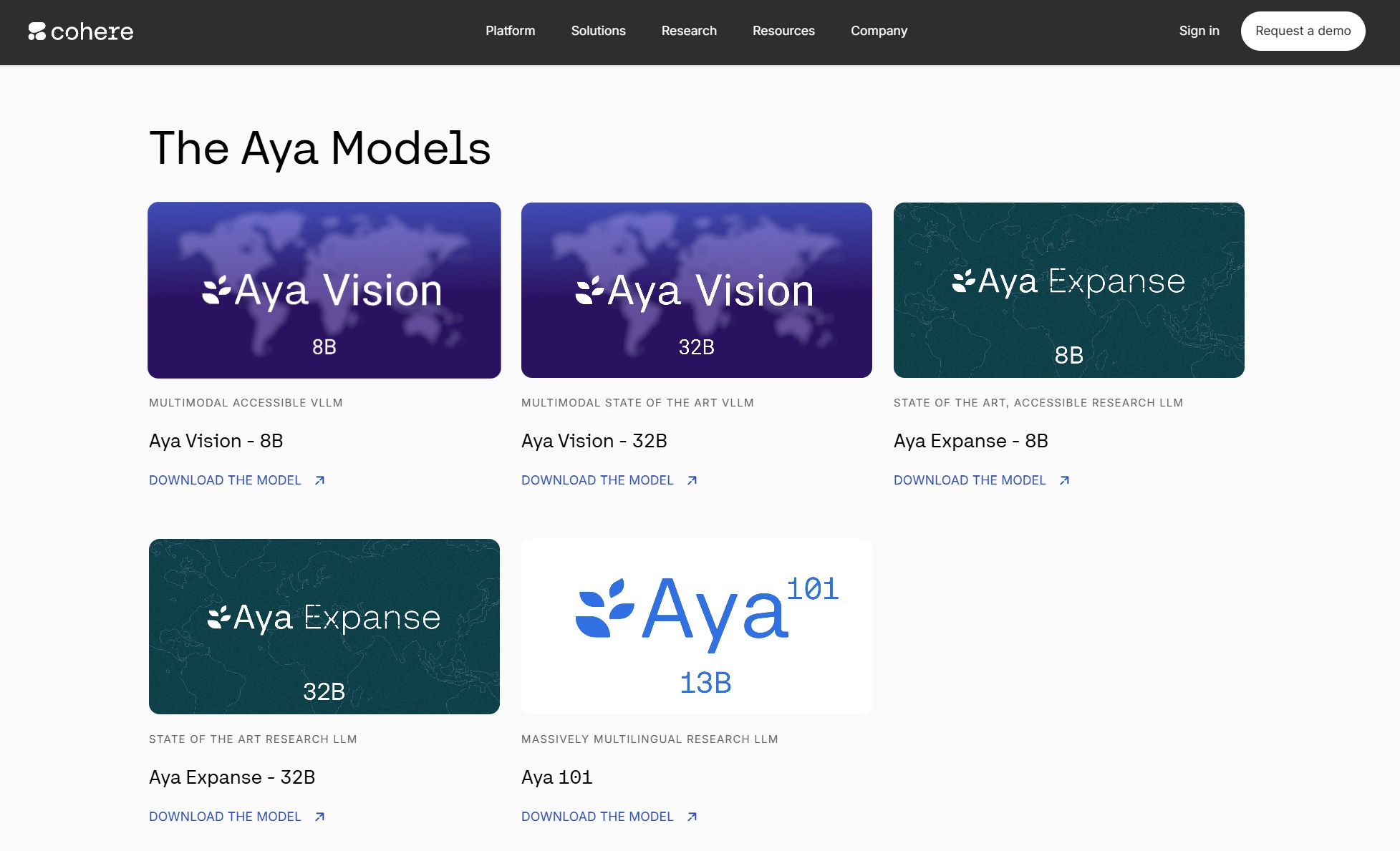

版本与性能

Aya Vision 提供两个版本:Aya Vision 32B 和 Aya Vision 8B。根据 Hugging Face:CohereForAI/aya-vision-8b 和 Hugging Face:CohereForAI/aya-vision-32b,32B 版本参数更多,适合需要更高性能的场景,而 8B 版本更注重计算效率,适合资源受限的环境。用户可以根据具体需求选择,例如研究机构可能偏向 32B,而小型企业可能更适合 8B。

应用场景

Aya Vision 的应用场景广泛,涵盖以下领域:

- 教育领域

它可以帮助学生和教师更好地理解视觉内容。例如,通过图像描述功能,学生可以快速了解艺术品的风格和起源,教师可以用它创建交互式课程。 - 内容创作

Aya Vision 能为多语言网站生成图像描述,提升用户体验。它还可以用于生成创意内容,如新闻报道、故事或诗歌,特别适合全球化的内容平台。 - 辅助工具

对于视觉障碍人士,Aya Vision 可以作为辅助工具,通过图像描述帮助他们理解周围环境。例如,智能手机应用可集成该模型,为用户实时描述相机捕捉的图像。 - 多语言翻译与交流

支持 23 种语言的文本翻译和摘要生成,能帮助用户跨越语言障碍进行交流,特别适合国际商务或旅游场景。 - 研究与开发

研究人员可以基于 Aya Vision 的高效性和多语言支持能力,探索新的应用场景,例如开发多语言视觉辅助系统或分析跨文化视觉内容。

开放源代码与可访问性

Cohere 以 Creative Commons Attribution-NonCommercial 4.0 International (CC BY-NC 4.0) 许可发布了 Aya Vision,允许研究人员和开发者在非商业用途下自由使用、修改和分享模型,前提是提供适当的署名。模型可在 Cohere 网站、Hugging Face:CohereForAI/aya-vision-8b、Hugging Face:CohereForAI/aya-vision-32b 上获取,用户还可以通过 Cohere Playground 或 WhatsApp 与模型交互。这种开放性和可访问性鼓励了 AI 社区的协作与创新。

性能对比与基准测试

研究表明,Aya Vision 在多个基准测试中表现出色,特别是在多语言和多模态任务上。根据 RoboFlow 博客:Cohere Aya Vision:多模态和视觉分析,8B 版本在与近期发布模型的定性测试中表现优异,而 32B 版本则在更复杂的任务上展现出更强的能力。这使得 Aya Vision 成为资源受限环境下的理想选择,同时也适用于高性能需求场景。

未来展望

Aya Vision 的发布标志着多模态 AI 向更包容、更高效的方向发展。其多语言支持和开放源代码特性可能激励更多开发者参与创新,特别是在教育、辅助技术和全球通信领域。随着 AI 技术的持续进步,Aya Vision 可能成为连接不同文化和语言的桥梁。

数据表:Aya Vision 关键参数对比

| 版本 | 参数规模 | 主要优势 | 适用场景 |

|---|---|---|---|

| Aya Vision 8B | 8 亿 | 计算效率高,资源占用少 | 小型企业、移动应用 |

| Aya Vision 32B | 32 亿 | 性能更强,处理复杂任务 | 研究机构、高性能需求场景 |

结论

Aya Vision 作为 Cohere 的一项创新成果,凭借其高效的性能、多模态和多语言支持能力,正在为全球用户提供全新的视觉内容处理体验。无论是教育、内容创作,还是研究开发,Aya Vision 都展现出了巨大的潜力。如果您正在寻找一款功能强大、易于使用的视觉模型,Aya Vision 绝对值得一试。