在人工智能领域,大语言模型(LLM)的应用越来越广泛,但随之而来的是计算资源的消耗和推理速度的瓶颈。SepLLM,由香港大学、华为诺亚方舟实验室等机构联合提出,为解决这一问题提供了全新的思路。SepLLM通过创新的分隔符压缩技术,显著提升了模型的推理效率和内存使用效率,成为大语言模型优化领域的又一重要突破。

SepLLM是什么?

SepLLM(基于分隔符压缩加速大语言模型的高效框架)是一种旨在加速大语言模型推理和训练的框架。它通过压缩段落信息并消除冗余标记,大幅提高了模型的计算效率和推理速度。SepLLM的核心创新在于利用分隔符(如标点符号)对注意力机制的贡献,将段落信息压缩到这些标记中,从而减少计算负担。

SepLLM在处理长序列(如400万个标记)时表现出色,同时保持了低困惑度和高效率。此外,它支持多节点分布式训练,并集成了多种加速操作,如fused rope和fused layer norm,进一步提升了训练效率。‘

SepLLM的主要功能

1. 长文本处理能力

SepLLM能够高效处理超过400万个标记的长序列,适用于文档摘要、长对话等需要维持上下文连贯性的任务。这一功能使得SepLLM在处理大规模文本数据时表现出色,能够满足各种复杂场景的需求。

2. 推理与内存效率提升

在GSM8K-CoT基准测试中,SepLLM将KV缓存使用量减少了50%以上,同时计算成本降低28%,训练时间缩短26%,推理速度显著提升。这意味着SepLLM不仅能够提高计算效率,还能降低资源消耗,为实际应用提供了更大的灵活性。

3. 多场景部署灵活性

SepLLM支持从零训练、微调和流式应用等多种部署场景,并能与预训练模型无缝集成。这一特性使得SepLLM在不同应用场景中具有广泛的适用性,能够满足各种不同的需求。

4. 支持多节点分布式训练

SepLLM的代码库支持高效的多节点分布式训练,并集成了多种加速训练的操作,如fused rope和fused layer norm。这一功能使得SepLLM在大规模训练场景中表现出色,能够显著提升训练效率。

SepLLM的技术原理

1. 稀疏注意力机制

SepLLM主要关注三类标记:初始标记、邻近标记和分隔符标记。在自注意力层中,SepLLM通过mask矩阵限制注意力计算范围,仅计算上述三类标记之间的注意力,从而实现稀疏化。这种稀疏注意力机制显著减少了计算量,提高了计算效率。

2. 初始标记(Initial Tokens)

初始标记是序列开始的若干标记,作为注意力的锚点。通过关注初始标记,SepLLM能够更好地捕捉序列的整体语义信息。

3. 邻近标记(Neighboring Tokens)

邻近标记是当前标记附近的标记,用于保持局部语义连贯性。通过关注邻近标记,SepLLM能够更好地捕捉局部上下文信息,从而提高模型的表达能力。

4. 分隔符标记(Separator Tokens)

分隔符标记如逗号、句号等,用于压缩存储段落信息。通过利用分隔符标记,SepLLM能够有效地压缩段落信息,减少计算负担。

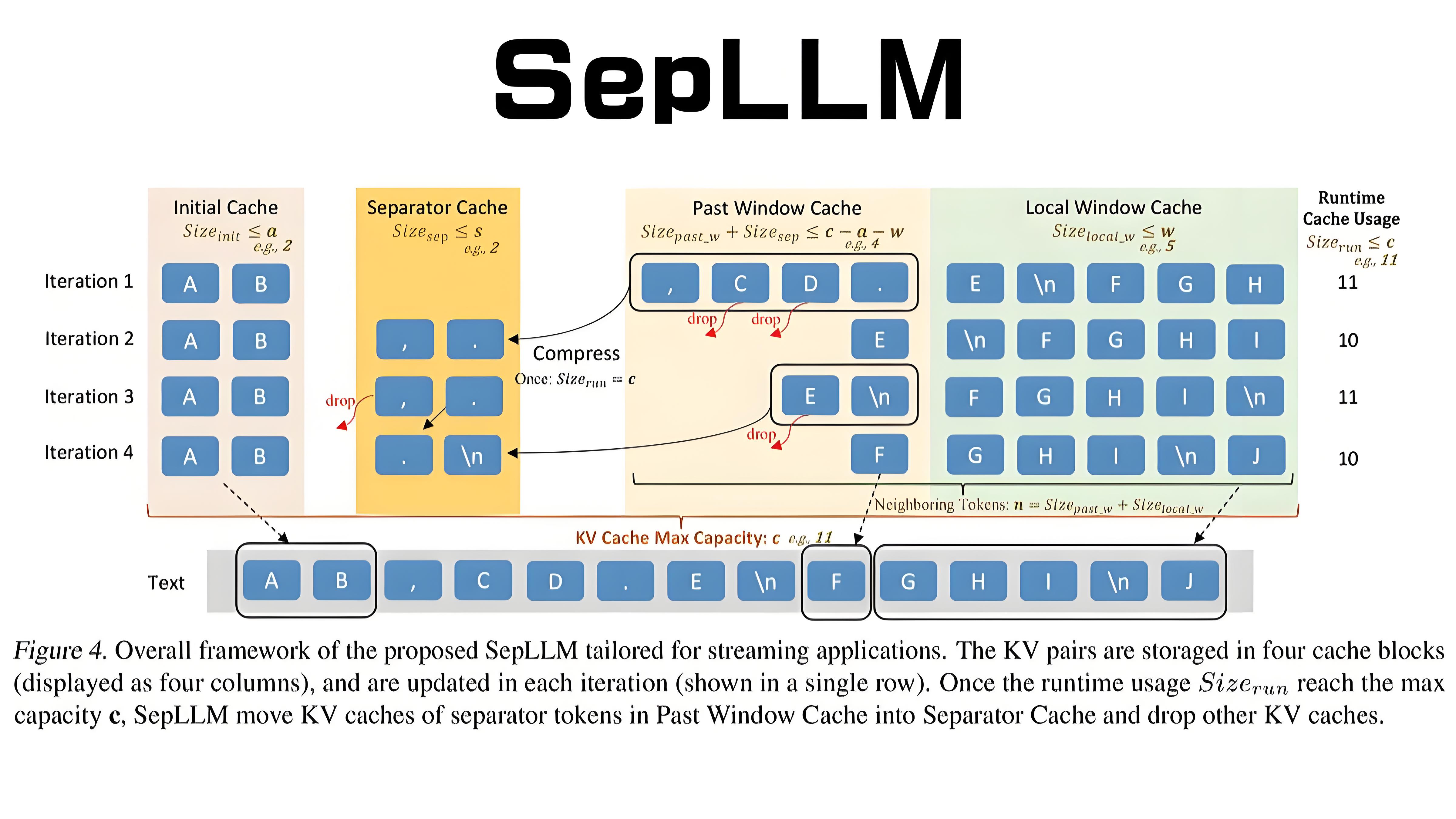

5. 动态KV缓存管理

SepLLM设计了专门的缓存块,包括初始缓存、分隔符缓存、历史窗口缓存和局部窗口缓存。通过周期性压缩和更新策略,SepLLM能够高效处理长序列,同时减少KV缓存的使用。

SepLLM的应用场景

1. 流式应用

SepLLM适用于多轮对话、实时文本生成等流式场景,支持无限长度输入,保持高效的语言建模能力。这一特性使得SepLLM在实时交互场景中具有广泛的应用前景。

2. 推理与内存优化

通过减少KV缓存和计算成本,SepLLM适用于资源受限的环境,如边缘计算、移动设备等,能够显著降低部署成本。

3. 工业应用

在大规模商业应用中,SepLLM能够降低部署成本,提升服务效率,支持高并发请求。这一特性使得SepLLM在工业界具有重要的应用价值。

4. 研究与创新

SepLLM为注意力机制优化提供了新的思路,支持多语言、特定领域优化和硬件适配等研究方向。这一特性使得SepLLM在学术研究中具有重要的意义。

SepLLM的项目地址

-

Github仓库:https://github.com/HKUDS/SepLLM

-

arXiv技术论文:https://arxiv.org/pdf/2412.12094

结语

SepLLM作为一种高效的框架,通过创新的分隔符压缩技术,显著提升了大语言模型的推理效率和内存使用效率。它在长文本处理、推理与内存优化、多场景部署灵活性以及支持多节点分布式训练等方面具有显著优势。无论是学术研究还是工业应用,SepLLM都为大语言模型的优化提供了全新的思路和解决方案。未来,随着技术的不断进步,SepLLM有望在更多领域发挥重要作用,推动人工智能技术的进一步发展。