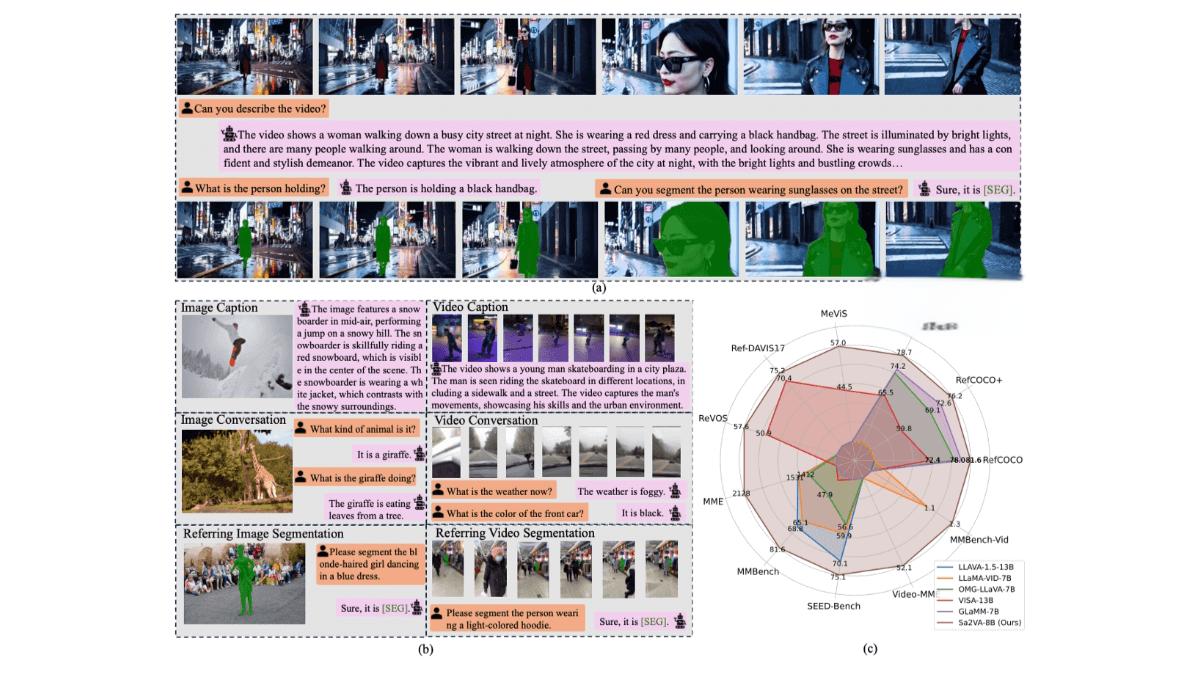

在人工智能领域,多模态大语言模型正在成为研究和应用的热点。Sa2VA作为字节跳动联合多家机构推出的多模态大语言模型,结合了SAM2和LLaVA的能力,能够实现对图像和视频的密集、细粒度理解。本文将详细介绍Sa2VA的功能、技术原理及应用场景,帮助读者全面了解这一创新模型。

Sa2VA的功能

Sa2VA具备多种功能,包括:

-

图像和视频指代分割:根据自然语言描述精确分割图像或视频中的目标对象。

-

图像和视频对话:支持与用户进行基于图像或视频的对话,回答与视觉内容相关的问题。

-

视觉提示理解:支持处理视觉提示(如图像中的框、点等),并结合语言描述生成对应的分割掩码或回答。

-

基于指令的视频编辑:根据用户指令对视频内容进行编辑。

-

密集的视觉理解:Sa2VA能理解图像和视频的整体内容,还能对像素级的视觉细节进行分析和操作,支持复杂场景下的细粒度任务,如长文本描述的视频对象分割。

-

零样本推理:支持在未见过的视频上进行推理,根据语言描述直接生成分割掩码或回答问题,无需额外训练。

技术原理

Sa2VA的技术原理主要包括以下几个方面:

-

模型架构:结合SAM2和LLaVA。SAM2负责视频的时空分割,LLaVA提供语言理解和生成能力。两者基于特殊的[SEG]令牌连接,LLaVA的输出作为SAM2的输入,指导其生成分割掩码。

-

统一任务表示:将多种任务(如指代分割、视觉对话、视觉提示理解等)统一为单次指令调整过程。所有输入(图像、视频、文本)被编码为视觉令牌,输入到LLM中,输出文本或分割掩码。

-

解耦设计:基于解耦设计,冻结SAM2的解码器和记忆模块,保留其感知和跟踪能力。

-

Ref-SAV数据集:引入Ref-SAV数据集,包含超过72k个复杂视频场景中的对象表达。数据集基于自动标注管道生成,包含长文本描述和复杂场景,提升模型在复杂环境下的性能。

-

时空提示:基于LLaVA生成的[SEG]令牌作为SAM2的时空提示,指导生成精确的分割掩码。

-

联合训练:在多个数据集上进行联合训练,包括图像QA、视频QA、图像分割和视频分割数据。

应用场景

Sa2VA的应用场景非常广泛,包括:

-

视频编辑:根据语言指令快速移除或替换视频中的对象,提升创作效率。

-

智能监控:基于语言描述实时识别和跟踪监控画面中的目标,助力安防监控。

-

机器人交互:理解指令并操作,如“拿起红色杯子”,增强机器人与环境的互动。

-

内容创作:为图像或视频生成描述和问答,辅助教育或创意写作。

-

自动驾驶:识别和分割道路场景中的行人、车辆等,辅助驾驶决策。

项目地址和资源

Sa2VA的项目地址如下:

-

HuggingFace模型库:https://huggingface.co/ByteDance/Sa2VA

-

arXiv技术论文:https://arxiv.org/pdf/2501.04001

结语

Sa2VA作为字节跳动开源的多模态大语言模型,展现了其在图像和视频理解领域的强大能力。无论是开发者、研究人员还是企业用户,都可以从中找到适合自己的应用场景。我们期待Sa2VA在未来能够发挥更大的作用,推动人工智能技术的进一步发展。