Video-LLaVA2是什么

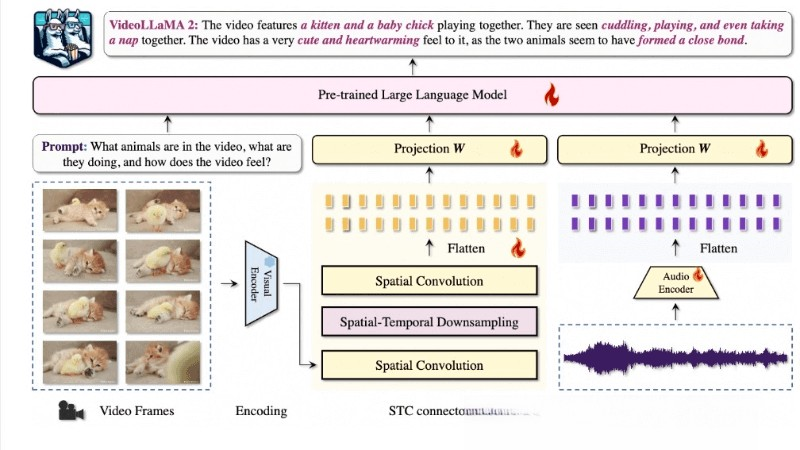

Video-LLaVA2是由北京大学ChatLaw课题组推出的开源多模态智能理解系统,通过创新的时空卷积(STC)连接器和音频分支,提升了视频和音频理解能力。模型在视频问答和字幕生成等多个基准测试中表现出色,与一些专有模型相媲美,同时在音频和音视频问答任务中也展示了优越的多模态理解能力。

Video-LLaVA2的主要功能

- 视频理解:能准确识别视频中的视觉模式,并理解随时间变化的情景。

- 音频理解:集成了音频分支,可以处理和分析视频中的音频信号,提供更丰富的上下文信息。

- 多模态交互:结合视觉和听觉信息,提供更全面的理解和分析视频内容的能力。

- 视频问答:在多项视频问答任务中表现出色,能准确回答关于视频内容的问题。

- 视频字幕生成:能为视频生成描述性字幕,捕捉视频的关键信息和细节。

- 时空建模:通过STC连接器,模型能更好地捕捉视频中的时空动态和局部细节。

Video-LLaVA2的技术原理

- 双分支框架:模型采用视觉-语言分支和音频-语言分支的双分支框架,各自独立处理视频和音频数据,然后通过语言模型进行跨模态交互。

- 时空卷积连接器(STC Connector):一个定制的模块,用于捕捉视频数据中的复杂时空动态。与传统的Q-former相比,STC连接器更有效地保留空间和时间的局部细节,同时不会产生大量的视频标记。

- 视觉编码器:选择图像级的CLIP(ViT-L/14)作为视觉后端,与任意帧采样策略兼容,提供灵活的帧到视频特征聚合方案。

- 音频编码器:BEATs等先进的音频编码器,将音频信号转换为fbank频谱图,并捕捉详细的音频特征和时间动态。

Video-LLaVA2的项目地址

- GitHub仓库:https://github.com/DAMO-NLP-SG/VideoLLaMA2?tab=readme-ov-file

- arXiv技术论文:https://arxiv.org/pdf/2406.07476

- 在线体验链接:https://huggingface.co/spaces/lixin4ever/VideoLLaMA2

如何使用Video-LLaVA2

- 环境准备:确保计算环境中安装了必要的软件和库,包括Python、PyTorch、CUDA(如果使用GPU加速)以及Video-LLaVA2模型的依赖包。

- 获取模型:从Video-LLaVA2的官方GitHub仓库下载或克隆模型的代码库。

- 数据准备:根据应用场景,准备视频和/或音频数据。数据应该是模型能处理的格式,例如视频文件可能需要转换为帧序列。

- 模型加载:使用Video-LLaVA2提供的代码加载预训练的模型权重。涉及到加载视觉和音频编码器,以及语言模型。

- 数据处理:将视频帧和音频信号输入模型进行处理。视频帧需要预处理,如调整大小、归一化等,匹配模型的输入要求。

- 模型推理:使用模型对输入数据进行推理。对于视频理解任务,包括视频问答、视频字幕生成等。

Video-LLaVA2的应用场景

- 视频内容分析:自动分析视频内容,提取关键信息,用于内容摘要、主题识别等。

- 视频字幕生成:为视频自动生成字幕或描述,提高视频的可访问性。

- 视频问答系统:构建能回答有关视频内容问题的智能系统,适用于教育、娱乐等领域。

- 视频搜索和检索:通过理解视频内容,提供更准确的视频搜索和检索服务。

- 视频监控分析:在安全监控领域,自动检测视频中的重要事件或异常行为。

- 自动驾驶:辅助理解道路情况,提高自动驾驶系统的感知和决策能力。

© 版权声明

本站文章版权归奇想AI导航网所有,未经允许禁止任何形式的转载。